Pure vision + A-A-A-Miggle think tank. Lo siento

Recuerda cuando éramos pequeños y empezamos a imaginar un coche artificialmente inteligente debido a un Thunder Ranger, y ahora por supuesto estamos en realidad. Hoy tenemos la respuesta. Es el extremo. Lo siento

Puede que no estés familiarizado con ello, pero podrías mirar el “poder” detrás de él. Como primer coche bajo el nombre de la marca Gigi-Bendu, no sólo tiene el oro de la vasta estructura de Gigi-SEA, sino también el programa de conducción de visión pura, que se ha dado el poder de 100 grados, pero también ha sido uno de los pioneros en el uso de marcas autónomas en el campo de la tecnología. Entonces, ¿cómo se siente en la experiencia real de este programa de conducción inteligente? EV tuvo el privilegio de acercarse al nuevo coche y tuvo una buena experiencia de él a través de una unidad de prueba corta. Lo siento

voy a divertirme un poco

empecemos con el programa de conducción de 100 grados, de 100 grados, totalmente controlado. lo siento

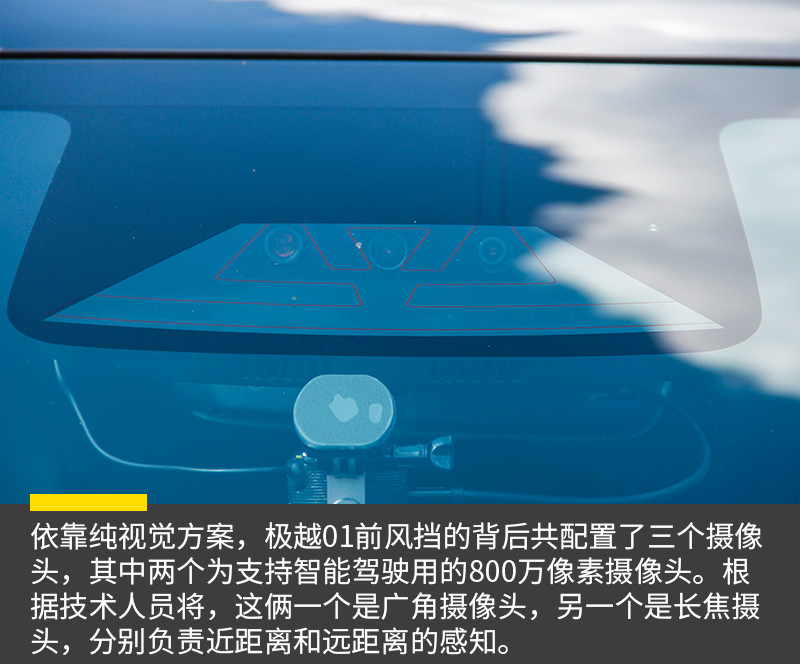

sabemos que más del 90% de los programas de conducción inteligente de alto nivel en el mercado actual utilizan programas de sensores multiintegrados, principalmente radar láser o radar de onda de milímetro, y en particular la inclusión de radar láser, lo que da a los conductores inteligentes la capacidad de un “kilometre-eye” y amplía aún más la distancia de la exploración sensorial. sin embargo, como todo es bueno y malo, el radar láser, aunque mucho más distante, ha aumentado indirectamente el costo de la compra de un coche debido a su propio precio, es decir, comprar un coche con un modelo de alto nivel, inteligente-drive, que es una de las razones para introducir una solución puramente visual. lo siento

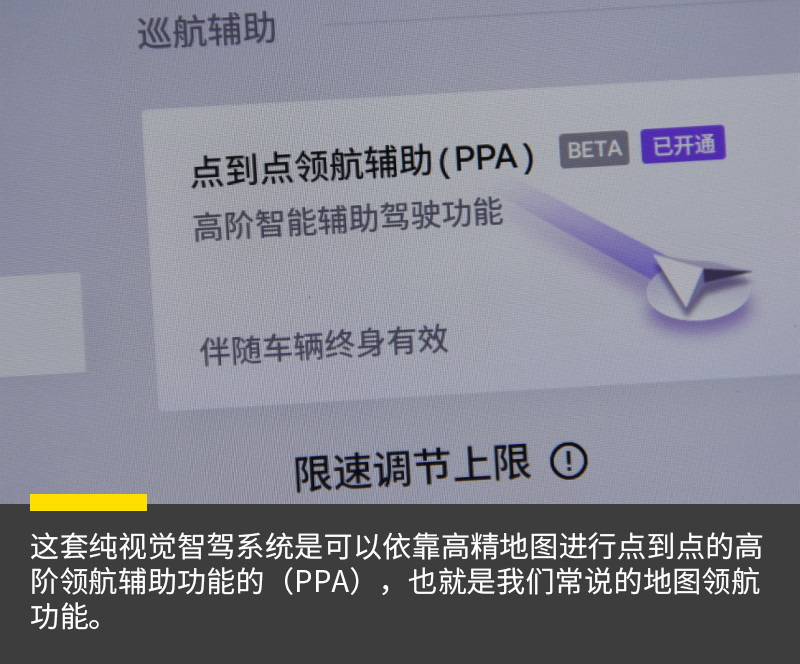

¿Las soluciones de visión pura son fáciles de lograr? Es muy difícil, después de todo, dar a una persona que posee un programa de conducción cerebral basado en los sentidos de vídeo el pensamiento general y el reconocimiento de que el algoritmo súper alto detrás de él juega un papel crucial. El BEV+Transformer y el Programa Visual Puro utilizando la Red de Ocupación, basado en el doble chip NVIDIA DRIVE Orin, AI calcula 508 TOPS y lleva 28 sensores de unidad inteligentes, incluyendo 11 cámaras de alta resolución (de las cuales 7 millones de píxeles son los más grandes de la industria), 12 radares de ultrasonido y 5 radares de onda de milímetro. Lo siento

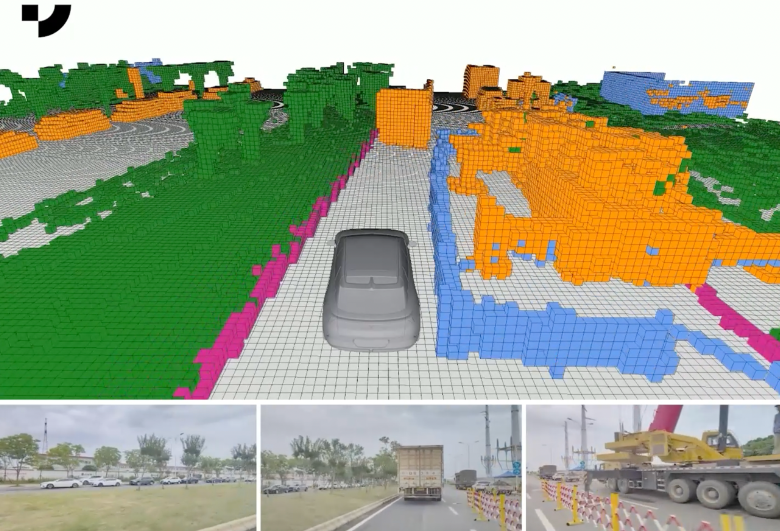

El llamado programa sensorial BEV, el conjunto de la vista de los ojos de los pájaros, significa la visión visual-céntrica. En general, la mayoría de los automóviles del país han optado por programas de sensorización multiintegrados con características visuales y de radar, pero en común necesitan obtener señales visuales o datos de otros sensores para realizar análisis integrados de computación y luego planificar sus pistas a través del procesamiento sistemático. En el proceso, sin embargo, los datos recopilados por cada sensor independiente a menudo se limitan por una perspectiva particular y, después de sus propios cálculos analíticos, la fase de integración puede llevar a una combinación de errores y errores que no permiten una imagen completa y precisa de la situación real en la carretera y dificultan que los vehículos planteen sus decisiones. Lo siento

La red sensorial de conducción automática BEV integra la colección de datos multisensor, transforma la escena alrededor del coche en una vista peri-view, reconstruye los elementos de carretera estática y los pounceres de carretera alrededor en tiempo real, y consigue una alta precisión capacidad sensorial de dirección completa. Es como una “Perspectiva de Dios” desde una perspectiva de alto nivel, donde los datos recogidos por múltiples sensores en un vehículo se introducen en un modelo uniforme para el análisis general y el razonamiento para producir la visión de pájaro, que puede ser eficaz para evitar superposiciones de errores. Lo siento

BEV+Transformer, por otro lado, convierte imágenes 2D a una vista de pájaro 3D a través de un modelo perimétrico a gran escala, y logra mapas locales en tiempo real y pruebas de reconocimiento 3D, sin embargo autoconducir no es sólo una percepción, sino más importante, cómo mejor conducir decisiones como pilotos humanos. La Superintendencia de los Modelos Cognitivos de Vigilancia proporciona una capacidad de autoaprendizaje, no un algoritmo de planificación basado en reglas, después de una amplia formación de datos. Lo siento

La última referencia a la ocupación de la red es también clave para una buena visión urbana del mundo real como un mundo de rejilla 3D, y ha convertido este espacio en innumerables subdivisiones rejillas, después de las cuales cada pequeño cuadrado se llama píxeles. Mientras esté ocupado en este espacio, el sistema considera uno, uno o cero. El objeto ocupa un determinado cuerpo en el espacio y el sistema lo muestra y determina que es una barrera. Lo siento

por lo tanto, basado en esta función, el algoritmo de conducción inteligente ya no tiene que lidiar con lo que son los objetos alrededor del vehículo, siempre y cuando se conozca la forma aproximada del objeto, el tamaño de la posición influirá en el movimiento, y el vehículo sabe si escapar o no. se solucionó el problema de identificar barreras genéricas. hasta entonces, la mayoría de los conductores de alto nivel tenían que ser etiquetados sistemáticamente para ayudar a los coches a entender qué coches, camiones, peatones y así sucesivamente eran, es decir, incluir objetivos de alta frecuencia en el mecanismo de lista blanca. sin embargo, el entorno de la carretera física es muy complejo, como pail de construcción, ramas caídas, mercancías caídas, etc. (barreras generales), y es poco probable que el fabricante incluya todos los objetos que puedan aparecer en la carretera en la lista blanca. así que, en la entrada, cuando un coche toca un objeto en la lista blanca, es capaz de hacer algo al respecto sin saberlo, y probablemente ignora o tiene otras respuestas de emergencia, como algunos de los accidentes de barril. lo siento

Entonces. La reversión de escenas 3D en la red, junto con las predicciones de BEV y Transformer de las trayectorias de los participantes en la carretera, hará que todo el módulo sensorial sea más completo. Luego los controles orbitales de abajostream pueden reducir el estrés, y el uso de la conducción inteligente puede ser más resbaladizo. Lo siento

muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy, muy

desafortunadamente, esta es una unidad de tiempo limitado que no explota completamente el potencial de este sistema de conducción inteligente puramente visual, pero después de una prueba simple, estamos más impresionados con el sistema, especialmente con su experiencia más suave, más modulada y acelerada, y esperamos que una nueva prueba en profundidad del coche tendrá lugar en un futuro próximo. lo siento

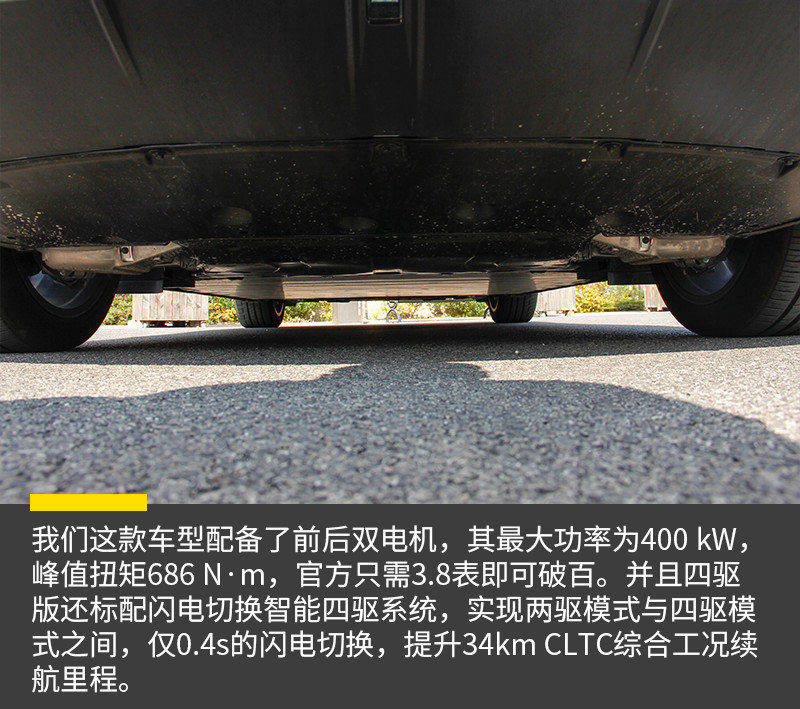

experiencia de conducción niusiangquan

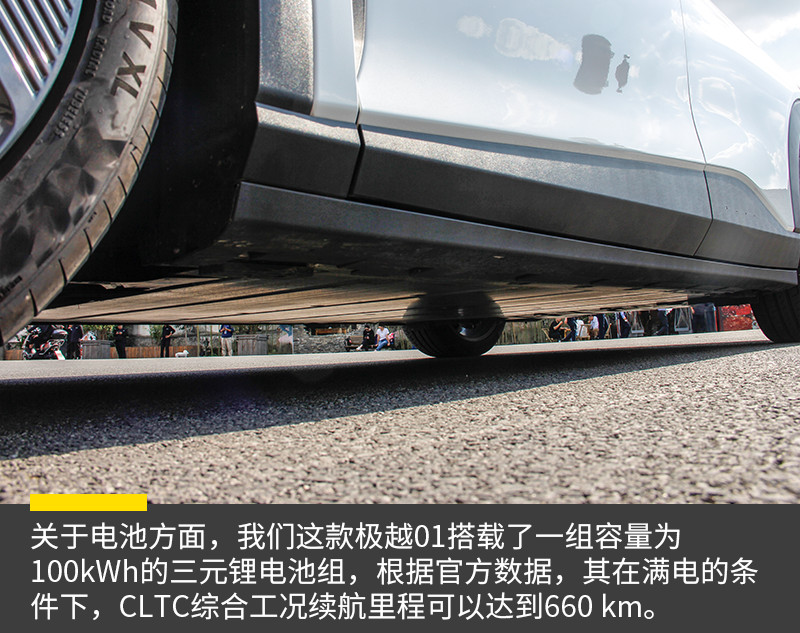

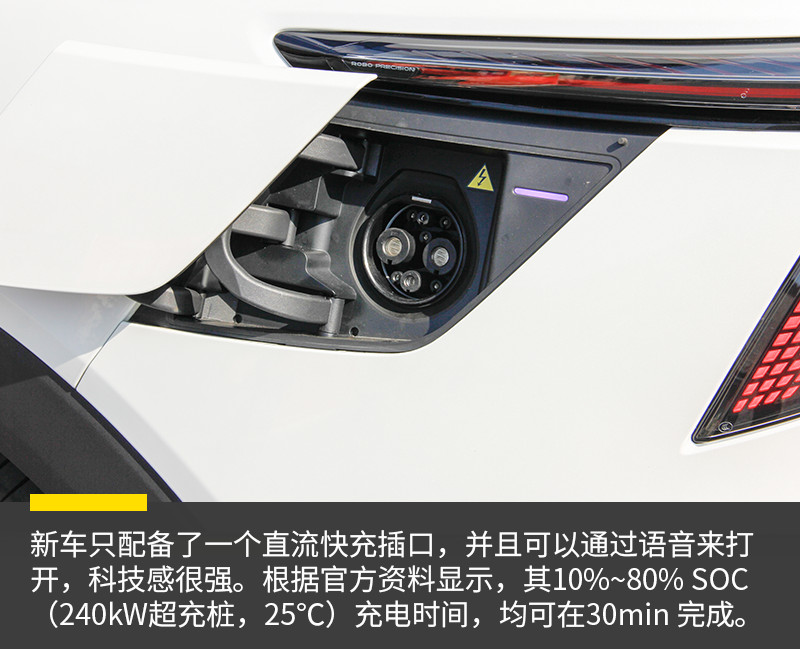

Se basa en la vasta estructura del Gigi-SEA, con dos versiones del lado de potencia, de las cuales el máximo poder de la versión de una sola potencia del extremo es de 200kW, el pico es de 343kW, y el máximo poder de la versión de dos potencias del extremo es de 400kW, el pico es de 686N.m., el tiempo de aceleración de 0-100km/h es de 3.8, y tenemos una versión piloto. Lo siento

nuevo coche lee niusiangquan

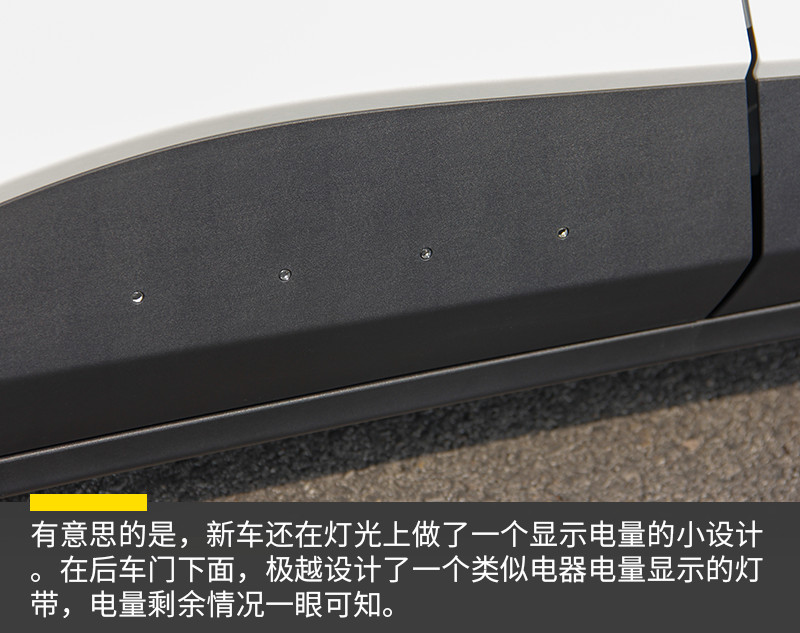

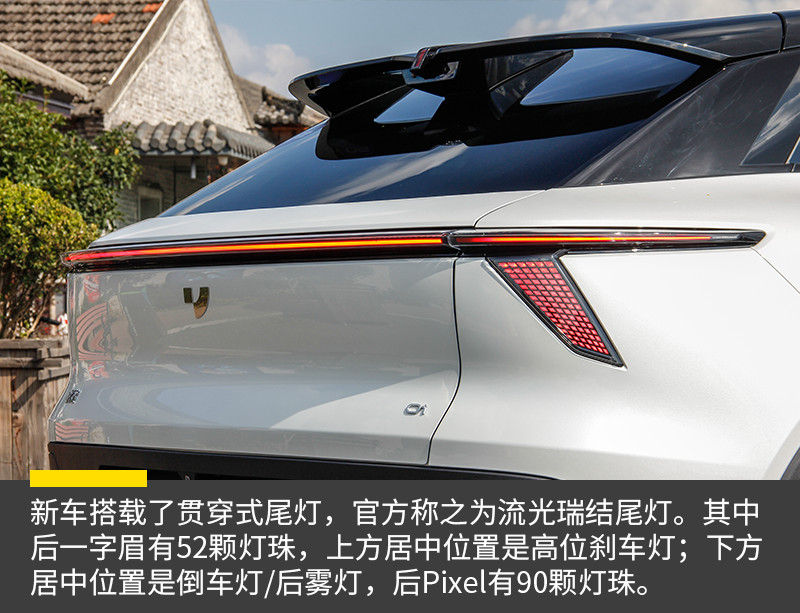

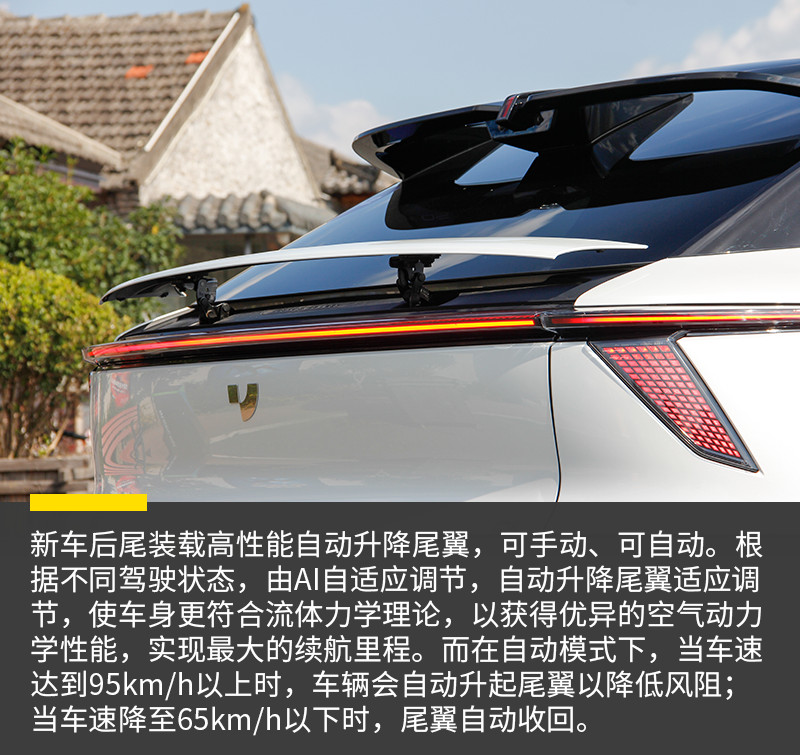

En términos de apariencia, los ultra-01s son en gran medida consistentes con la serie anterior de ROBO-01s e incluso se pueden entender como el mismo coche, con sólo un ajuste de nombre. El diseño general del nuevo vehículo es más conciso, con un diseño cerrado para la cara delantera, equipado con una luz diurna en marcha, que ya es el símbolo del nuevo vehículo energético. Por el contrario, el grupo muy grande de lámparas hasta 01 es único, haciendo que toda la visión frontal sea más tijera y más visible. Por otro lado, en el lado coloreado, los ultra-01 ofrecen la opción de estrellafish, naranjas brillantes, blancos brillantes, colores de ceniza y un coche ennegrecido. Lo siento

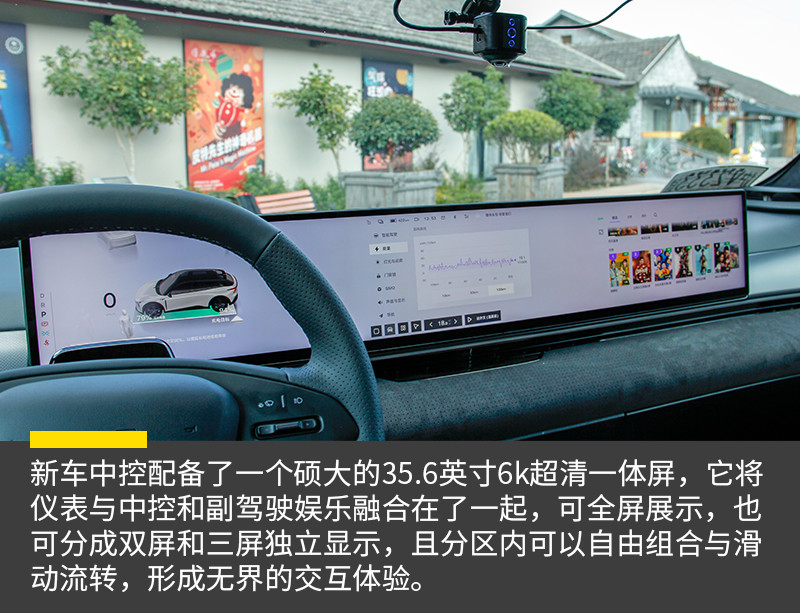

La sección interior, que está muy cerca de 01, está inspirada en el concepto de cabina de la nave espacial, con el lanzamiento del chip 8295, utilizando 35,6 pulgadas de pantalla cruzada y guía U, y la eliminación de la esfera de control de luz de interruptor tradicional, que está controlada por los botones en la rueda. Además, el modelo Ultra-01 ofrece configuraciones para almohadas de vuelo delantera y trasera, pantallas traseras, etc. Lo siento

En términos de configuración, el ultra-01 tiene un vehículo que transporta la plataforma de cámara digital HD-4 —el chip 8295— que utiliza una escala de 5nm, con AI calculando hasta 30 TOOPS, ocho veces más que el chip 8155, que no sólo conduce 11 pantallas, sino que también soporta la interacción 3D aislada. Y por primera vez, los dos NPU estaban totalmente operativos, con AI alcanzando 60 TOOPS, y con un fuerte cálculo de NPU, el nuevo coche podría apoyar el control de voz fuera del coche, el maestro ‘ s despertar, el hablar visible, las áreas de cuatro sonidos, y el reconocimiento semántico, para que el sistema de voz pudiera manejar todas las funciones del vehículo. Lo siento

está escrito al final en niusianangquan

se puede decir que este, llamado los “robots” por mucho más de 01, se puede decir que ha sido equipado y experimentado inteligentemente tan pronto como surgió para tomar la parte superior de la industria, y que, después de su fuerte respaldo de la tecnología de togiri y beadel, el futuro poder tecnológico en el mercado no debe ser subestimado, que también sería una fuente de buenas noticias para más usuarios que aman la tecnología del hacker. ¿entonces el coche tiene el potencial de explotar? vamos a dar tiempo para responder. lo siento